какой минимальный срок проведения аб теста

Какой минимальный срок проведения аб теста

A/Б-тестирование для новичков: что это такое и как его настроить

Маркетологи абэ-тестируют, абэ-тестируют, да не выабэтестируются.

Внимание, эта статья не для маркетологов — она для людей, которые делают классный продукт и с помощью лендинга хотят найти новых клиентов. Мы постарались максимально просто рассказать об А/Б тестировании, избежав нагромождения цифр и терминов.

Что такое А/Б тестирование

Это метод. Тест. С его помощью выясняется, как небольшие изменения в дизайне или подаче коммерческих предложений влияют на поведение людей на сайте.

Допустим, вы делаете лендинг, в котором отличаются некоторые элементы: например, цвет фона. Запускаете рекламу и разделяете входящий трафик на два потока: половина посетителей попадает на лендинг с синим фоном, а вторая половина на лендинг с красным фоном. Через некоторое время анализируете результаты и видите, что красный фон приносит больше заявок, чем синий. Оставляете его.

Маркетологи также называют этот метод сплит-тестирование, от английского слова split — раздельный.

Зачем нужно А/Б тестирование

А/Б тестирование проводят, когда хотят проверить предположение. Например:

Выбираете гипотезу, которую хотите проверить первой, тестируете ее и по результатам определяете — стоит ли вносить изменения на сайт.

А/Б тест на практике помогает определить, насколько ваша идея проверяется реальностью.

Целесообразно проводить эксперимент, если к вам на сайт заходит хотя бы 5000 человек в месяц. Если меньше — придется потратить много времени, чтобы накопить необходимую статистику.

Как часто проводят и сколько времени это занимает

Нет какого-то особенного графика для проведения А/Б тестов — вы запускаете эксперимент, когда появляется интересная гипотеза. Больше гипотез — больше тестов.

Время проведения зависит от идеи. Если вы внесли микро-изменение: поменяли цвет кнопки или загрузили новое изображение — может понадобиться два-три месяца, чтобы понять какой вариант лучше. Если изменения глобальные — уже через пару недель станет понятно, какой лендинг больше зашел.

Время проведения рассчитывают на специальном калькуляторе — он помогает определить период, за который наберется достаточное количество людей для статистики.

Калькулятор определяет, сколько людей должно поучаствовать в тесте, а дальше уже нехитрыми вычислениями можно прикинуть, сколько времени это займет.

Секреты A/B-тестирования: метрики, сроки и фичи, которые невозможно проверить

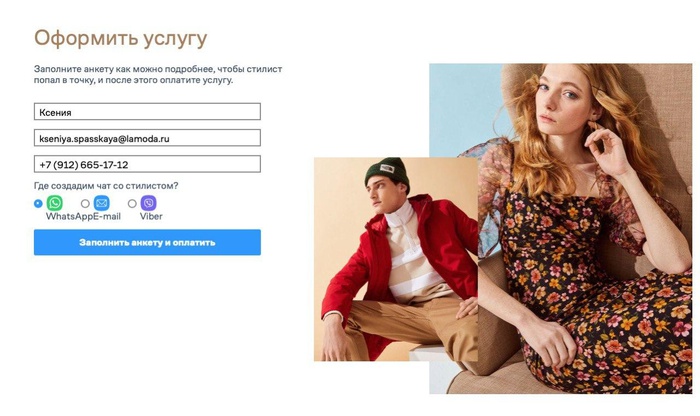

Менеджер продукта и сервиса Lamoda «Стилист»

Быстрые эксперименты помогают бизнесу эффективно определять пути развития. Об адекватных метриках, сроках и о том, какие фичи невозможно протестировать, рассказывает менеджер продукта и сервиса Lamoda «Стилист» Ксения Спасская.

Эффект в цифрах и без них

Прежде чем всем пользователям Lamoda станет доступен новый функционал, мы проводим A/B-тестирование. С этим менеджерам продукта помогает отдел дата-сайентистов и аналитиков. Они проверяют, влияет ли функционал на ключевые метрики, одна из которых — деньги.

Через тестирование проходит от 80 до 90% новых фич и продуктов платформы. Мы не тестируем те улучшения, результат внедрения которых нельзя измерить. Например, мы добавили на главную страницу приложения возможность переключаться сразу между несколькими разделами: подборка, каталог, избранное, профиль и корзина. Так как этот блок насквозь проходит все разделы платформы, ограничить аудиторию, которой он доступен, невозможно.

Новые бизнесы не всегда можно A/B-тестировать. В новейших проектах без аналогов слишком много неизвестных, неясны метрики. Непонятно, например, как именно статьи из блога влияют на решение о покупке конкретного товара и в какой временной перспективе. Но мы понимаем, что заход на страницу с текстом и его прочтение приносят эффект.

Классическая схема A/B-тестирования

Элементы эксперимента

Контрольная группа. Тестирование предусматривает наличие контрольной группы, характеристики которой определяют аналитики и специалисты по большим данным при помощи математического анализа. Группы формируют так, чтобы они дублировали поведение пользователей всех сегментов аудитории Lamoda. Для конкретного эксперимента продакт-менеджеры могут выбрать группу из заранее сформированных по определенным правилам.

Тестовые группы. У нас есть возможность раскатить новую фичу, например, только на сотрудников и даже только на одного пользователя. Можно открыть эксперимент для разных сегментов аудитории: по странам, по платформам, по группам. Классическая схема: 50% аудитории выступают как контрольная группа, другие 50% — как тестовая.

Открывать новую фичу просто на всех пользователей без сложных схем тестирования не очень эффективно для большого бизнеса: мы не поймем, действительно ли конкретное изменение повлияло на общую выручку или конверсию в покупку, не сможем спрогнозировать дальнейшие точки роста.

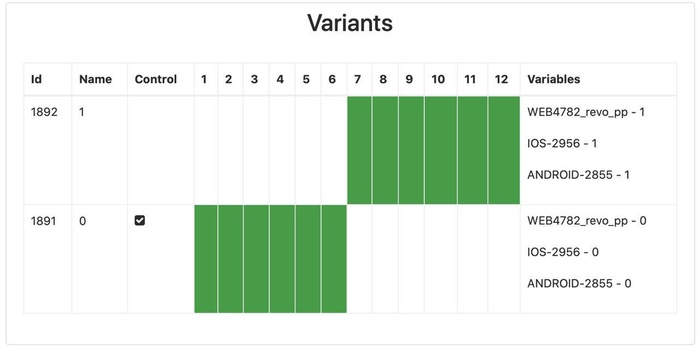

Вот так выглядит внутренняя админка сайта с двумя вариантами A/B-тестов.

Метрики. Стандартные метрики в A/B-тестировании — это срок, процент конверсии в покупку и рост выручки. Могут быть и чисто продуктовые метрики: в случае тестирования рекомендательной «полки» с товарами для пользователя нужно понять, сколько на ней должно быть карточек товара, удобно ли пользователю листать вбок.

В этом случае можно принять в качестве метрики количество карточек на полке рекомендаций. А при тестировании блока с возможностью оплаты с рассрочкой можно оценить и конверсию в покупку, и конверсию в заказ.

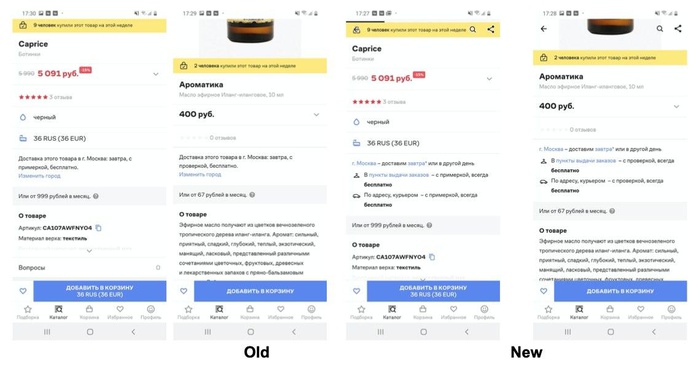

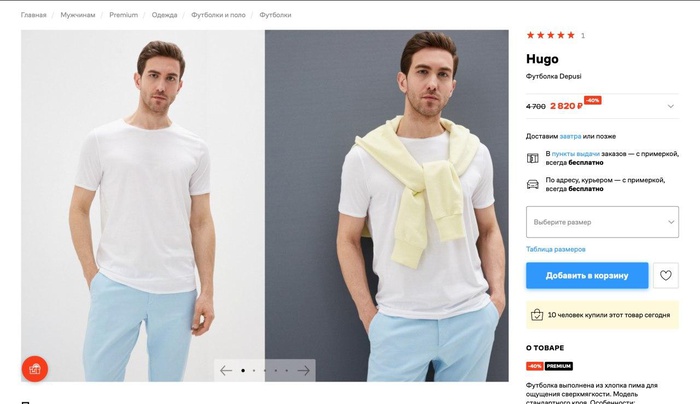

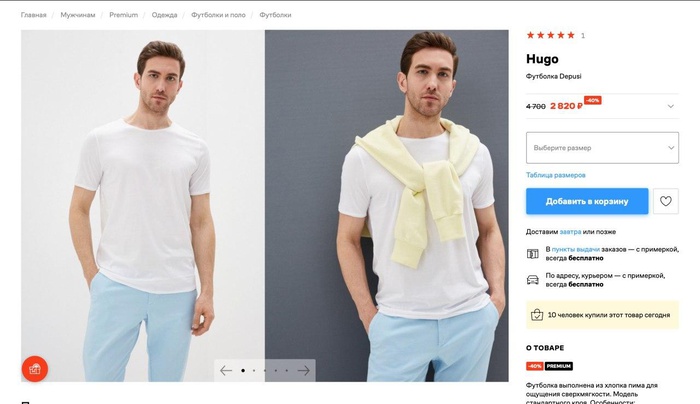

В блоке про доставку добавили информацию про условия бесплатной доставки.

Срок. Срок теста определяется исходя из перспектив набора статистической значимости — необходимого объема пользователей, которые бывают в разделе расположения новой фичи. В среднем наши тесты идут три-четыре недели. В менее посещаемых разделах эксперименты длятся дольше.

Пример эксперимента: перенос блока про доставку под кнопку «Добавить в корзину», так как исследование показало, что информация о выборе цвета и размера для пользователя важнее, чем информация о доставке.

A/B-тестирование на примере сервиса «Стилист»

Покупатели готовы тратить все меньше времени на подбор гардероба и хотят делегировать этот процесс. На этой гипотезе Lamoda построила новый сервис «Стилист» и запустила первые тесты осенью 2019 года. Так платформа старается расширить свой образ онлайн-магазина до онлайн-советчика и проводника в мир моды и образа жизни.

Первой задачей было понять, нужен ли нам такой проект и куда двигаться, чтобы он работал эффективно. Первые тесты мы проводили на небольшой части сотрудников. Это был простой сервис на коленке: таблица Excel, чат в Telegram, два стилиста, которые собирали капсульный гардероб для участников эксперимента.

Семь тысяч сотрудников компании — отличная база для любых исследований, потому что сегментация примерно совпадает с особенностями аудитории платформы. Сделав первые выводы, мы разработали самый простой сервис и предложили протестировать его уже всем сотрудникам. Система работы стала сложнее. Мы ожидали, что запросы будут в основном от женщин, но 50% заявок поступило от мужчин. Сотрудники сами выкупали подобранные вещи и вели себя как реальные клиенты.

Тесты проходили до начала пандемии, а весной 2020 года нам пришлось их приостановить: в условиях распространения заболевания на наши метрики нельзя было полагаться. Поведение пользователей сильно изменилось, и мы наблюдали это на всех продуктах. Тестировать новый сервис в таких условиях было рискованно.

Ключевые инсайты, которые мы получили: перед составлением капсулы важно хотя бы минимально разобрать гардероб клиента, чтобы не предлагать ему те вещи, которые у него уже есть; клиенты в основном ждут эффекта «вау» и преображения.

Эти отзывы помогли нам доработать коммуникацию и объяснить особенности нашей услуги. Мы усовершенствовали анкету, чтобы пользователь мог рассказать нам о своем гардеробе.

30 сентября 2020 года услуга стала доступна всем пользователям сервиса в тестовом режиме, эксперимент будет идти до конца октября. Пока результаты схожи с итогами нашего внутреннего тестирования. Единственное отличие: пользователей-мужчин немного меньше, чем внутри компании: 20% аудитории.

A/B-тестирование в вашей компании

Эксперименты и анализ их результатов помогают нам расставлять приоритеты, выявлять точки роста, четко понимать, что именно нужно улучшать для увеличения оборота компании. Благодаря тестам выводы максимально точны и это позволяет эффективно развивать продукт.

Разработка системы A/B-тестирования довольно сложная. Чтобы система работала качественно, нужны существенные вложения и специалисты. Если того и другого нет и речь идет о стартапе с понятной и небольшой аудиторией, то что-то улучшать можно и на основе сбора обратной связи от пользователей. Сложные алгоритмы тестирования будут избыточны.

A/B-тестами имеет смысл заниматься в том случае, когда компания уже нарастила аудиторию в несколько миллионов и не может проводить глубинные интервью. Тогда в ход идут исследования, масштабные опросы и анализ поведения.

Как получить максимум от A/B-тестов

Фото на обложке: Shutterstock/aanbetta

Изображения в тексте предоставлены автором

Как запустить А/Б тест

А/Б тесты — мощный инструмент маркетолога. Они помогают постоянно улучшать коммуникацию с посетителями сайта: тестировать и выбирать те элементы, которые с большей вероятностью убедят их совершить целевое действие, например, покупку. В этой статье мы расскажем, что такое А/Б тесты, зачем они нужны, как правильно их проводить и анализировать результаты.

Руководитель команды внедрения Carrot quest Женя Аликин постоянно проводит А/Б тесты для наших клиентов. Он поделился своим опытом и интересными кейсами на вебинаре. Про некоторые из них мы написали в статье, остальные можно посмотреть в записи:

Что такое А/Б тесты и зачем они нужны

Зачем делать А/Б тесты:

1. Быстрее проверять гипотезы.

Вас не устраивает конверсия в заявку на лендинге. Предположим, что его полная переделка займет месяц, потребует участия целой команды и не гарантирует изменений в конверсии. А если вы проведете А/Б тест отдельных элементов, то увидите изменения уже через одну-две недели, и этот процесс потребует значительно меньше ресурсов.

2. Принимать решения на основе данных.

Вносите изменения, которые подсказывают подтвержденные данные, а не интуиция. Вы можете проверять любые элементы страницы и видеть по результатам А/Б теста, какой вариант лучше остальных на основе статистики.

3. Получать полезные инсайты.

А/Б тесты помогут понять целевую аудиторию и узнать, как с ней лучше работать. Те каналы коммуникации и ценности, на которые вы рассчитывали больше всего, могут попросту не сработать.

Например, на сайте онлайн-сервиса по созданию фотобуков Mofy.life протестировали два варианта писем:

Удивительно, но CTR обычного письма оказался выше: 13,63% против 9,92%.

Почему нельзя отправить всем сначала одно письмо, а через неделю другое, и сравнить результат

А/Б тесты помогают исключить влияние внешних факторов вроде сезонности, рекламных кампаний и дней недели.

Например, вы провели успешную рекламную кампанию и привели на сайт заинтересованных в продукте лидов. Будет некорректно сравнивать эффективность сообщения, которое отправили этой группе, с эффективностью сообщения, которое отправили в другое время для нецелевого или совсем холодного трафика. Точный результат можно получить, если учесть и минимизировать влияние подобных внешних факторов.

Сообщения показываются в один и тот же период времени, а люди в каждую из групп (А или Б) выбираются случайным образом.

Что можно тестировать

Всё, что может влиять на поведение пользователей. Чаще всего А/Б тесты применяют для оптимизации емейл-рассылок, поп-апов, сообщений в чат.

Что можно протестировать:

В первую очередь протестируйте ценности для клиента и общие формулировки. Такие тесты быстрее дадут статистически значимый результат и покажут разницу в конверсии. Для роста важнее ценность, которую вы предлагаете, а не кнопки и шрифты.

Лучше не тестировать мелочи вроде цвета кнопок, потому что на получение значимого результата у вас уйдут месяцы. За время такого теста продукт или сайт могут измениться, и тест потеряет свою актуальность еще до того, как вы получите результат.

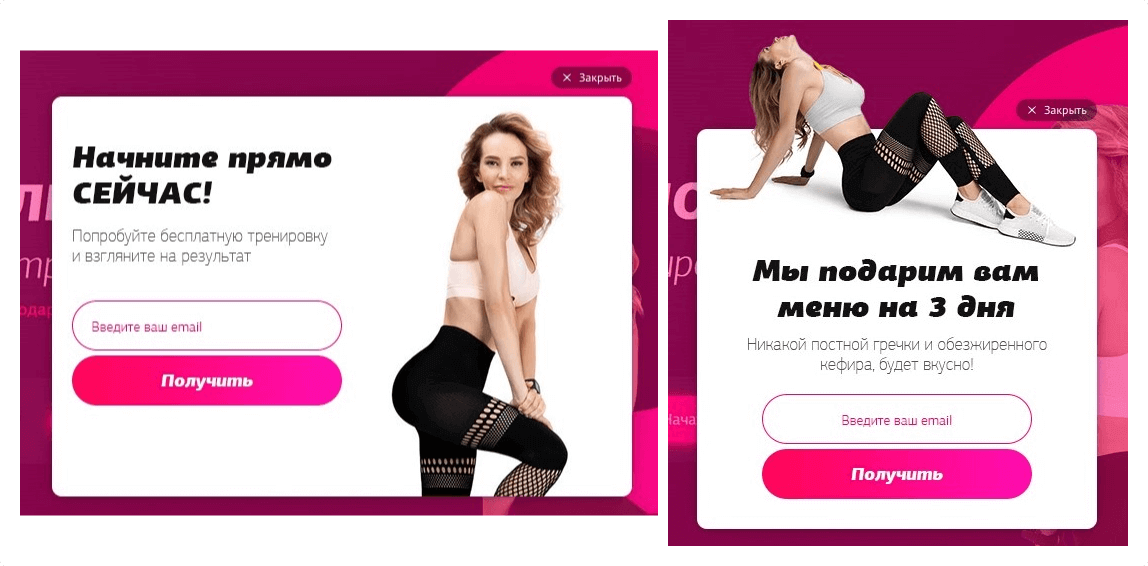

В одном проекте мы тестировали оффер на сайте курсов по улучшению фигуры. В первом варианте пользователю предлагали бесплатную тренировку, а во втором — меню на три дня:

Конверсия варианта А — 3,91%, варианта Б — 6, 34%, это значительная разница. Мы предполагаем, что второй вариант оказался эффективнее по двум причинам:

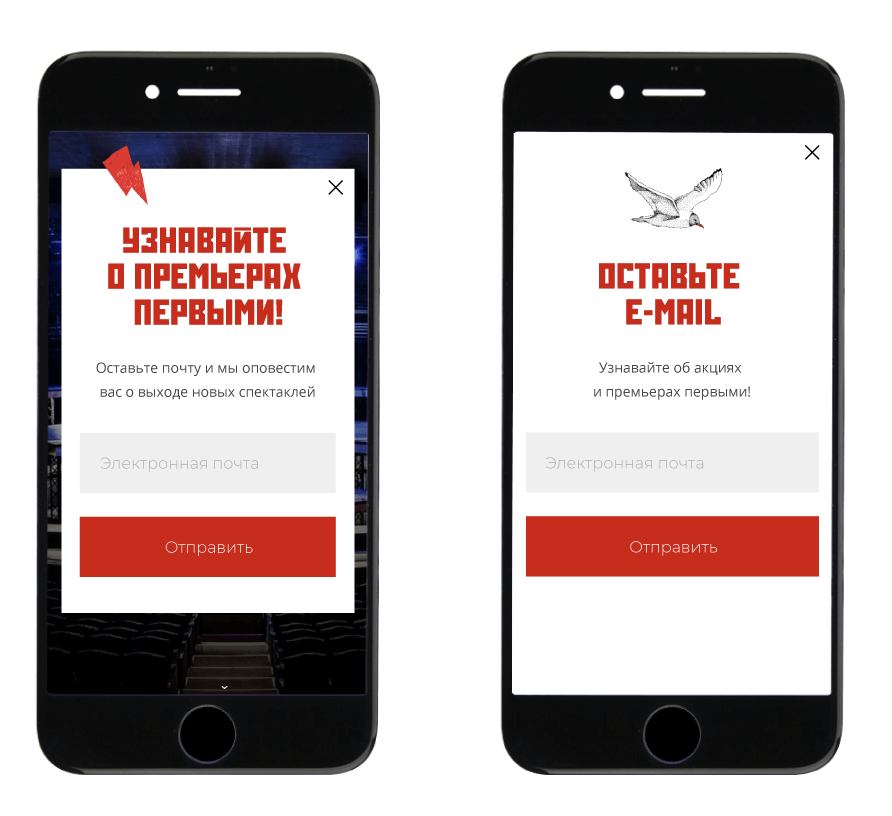

Примеры А/Б тестов

Здесь мы собрали примеры А/Б тестов, которые проводила команда внедрения Carrot quest для наших клиентов.

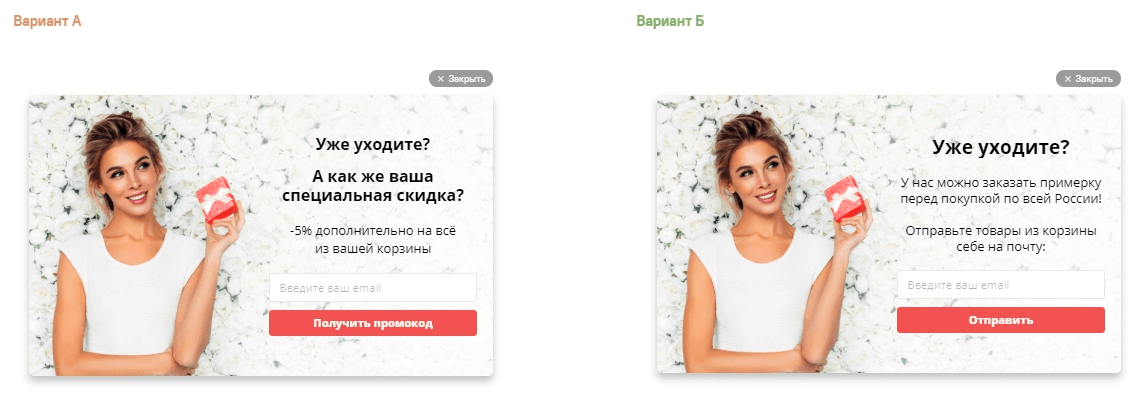

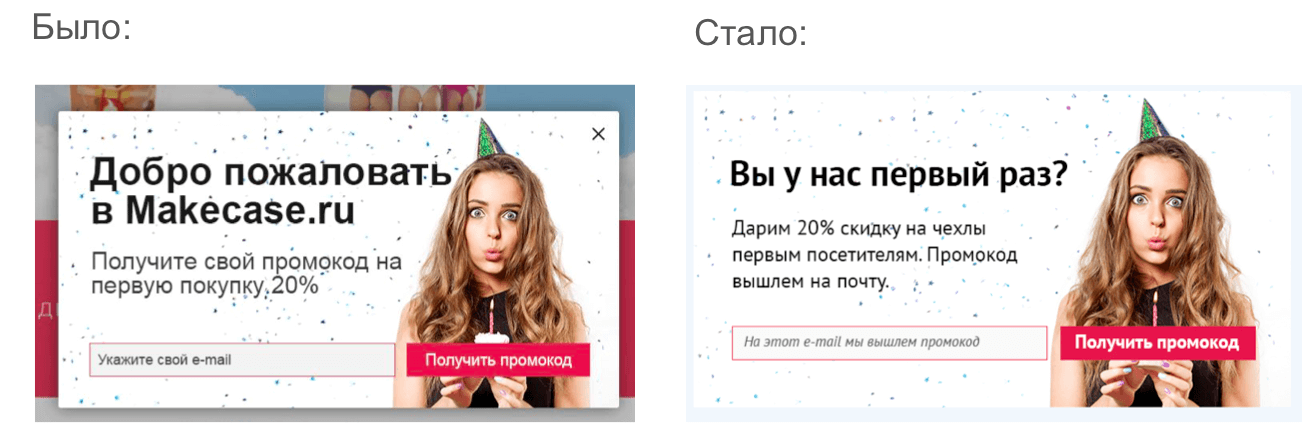

1. Поп-апы на сайте интернет-магазина одежды:

Конверсия первого поп-апа — 1,75%, конверсия второго меньше в 10 раз — 0,18%.

В варианте А оффер показывает ценность, а в варианте Б — сразу подталкивает к действию:

Конверсия в емейл у первого поп-апа составила 1,16%, а у второго — 4%. Поп-ап с призывом к действию работает лучше, потому что пользователи сразу понимают, чего от них хотят, и легче оставляют емейл.

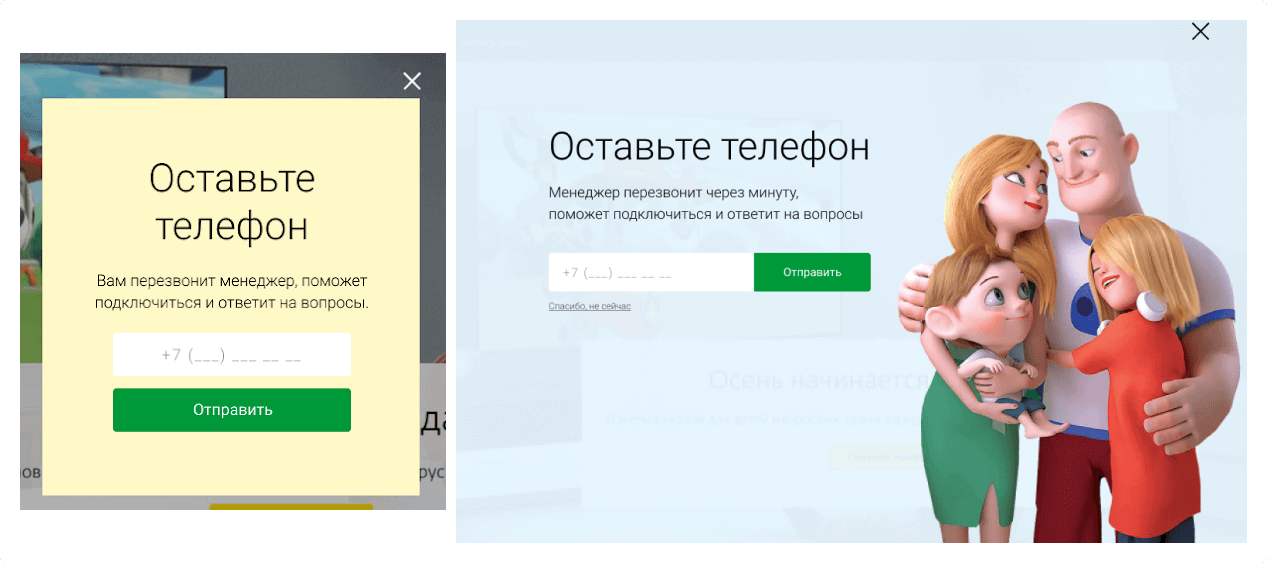

3. Поп-апы, которые собирают номера телефонов на сайте крупного интернет-провайдера:

Поп-ап со счастливым семейством лучше привлекает внимание. Его конверсия в телефон составила 3,1% против 2,18% у небольшого поп-апа.

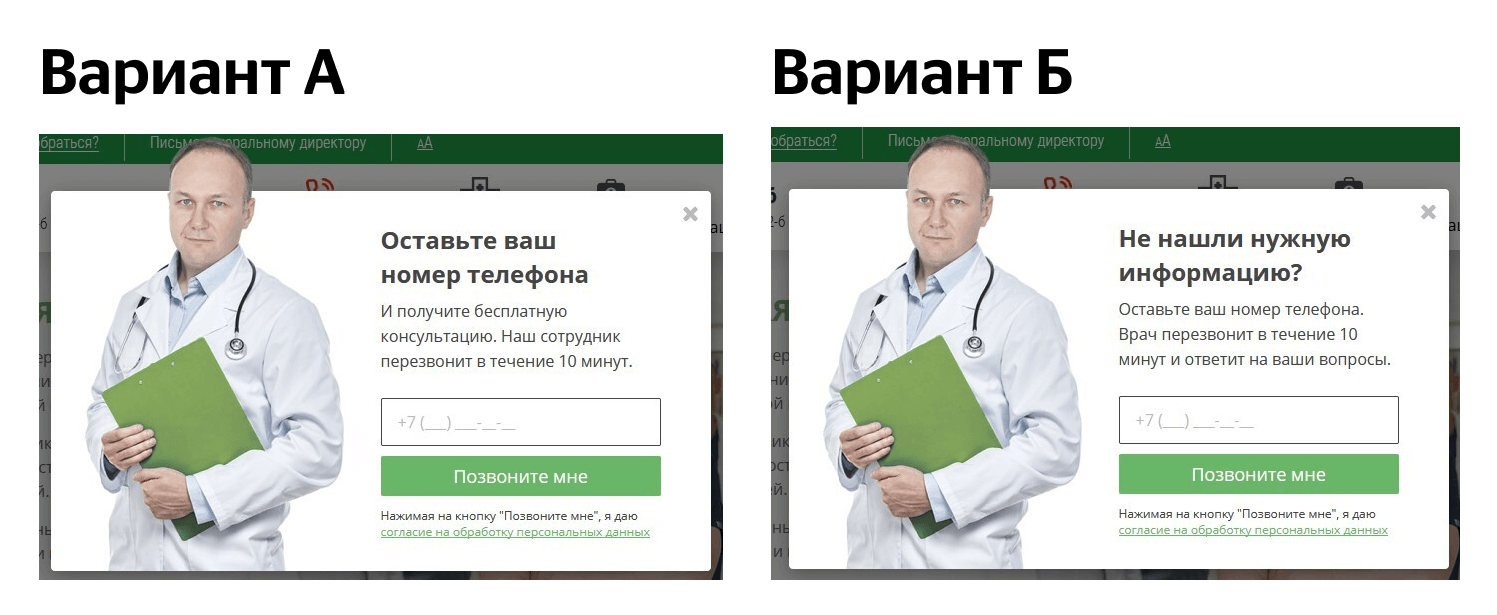

4. Поп-апы на сайте клиники:

Конверсия в телефон у первого поп-апа — 0,44% против 0,25% у варианта Б. Чаще всего люди не читают мелкий текст, поэтому призыв к действию должен быть заметен.

Как определить, сколько времени займет А/Б тест

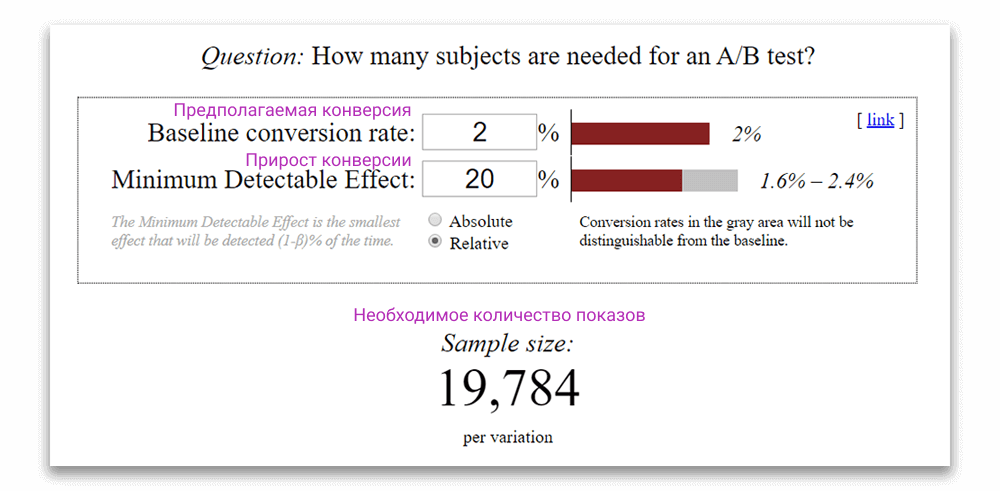

Оценивать А/Б тесты можно с помощью калькулятора Эвана Миллера. Чтобы понять, сколько времени займет А/Б тест и стоит ли его проводить, вам понадобится информация о:

С помощью калькулятора Эвана Миллера вы сможете рассчитать количество показов, необходимое для получения статистически значимого результата. Если соотнести количество показов с примерным трафиком на сайте, можно определить, сколько времени займет А/Б тест и стоит ли его проводить.

Если А/Б тест потребует слишком много времени, лучше его не запускать: ваше предложение может измениться, а время и силы будут потрачены впустую. Поменять цвет кнопки, ждать 6 месяцев и получить разницу в конверсии в 0,5% — очень сомнительное удовольствие и не позволит проекту кратно расти.

Бывают А/Б тесты, которые проводят от нескольких месяцев до полугода, и они тоже могут окупиться, если компания продает товары с высоким ценником. Например, покупка одного автомобиля или загородного дома часто окупает полугодовые или годовые затраты на автоматизацию маркетинга.

Предположим, что трафик на сайте — 50 тысяч пользователей в месяц. Вы тестируете два варианта поп-апа со сбором емейлов.

Вносим данные в калькулятор. Он рассчитал, что на каждый из вариантов нужно 19 784 показов:

Вычитаем часть аудитории сайта, которой не хотим показывать сообщение. Например, текущие клиенты — у них мы уже знаем емейл.

Остаётся 45 тысяч пользователей.

Нужно 19 784*2 показов.

Получается, что на этот тест понадобится месяц.

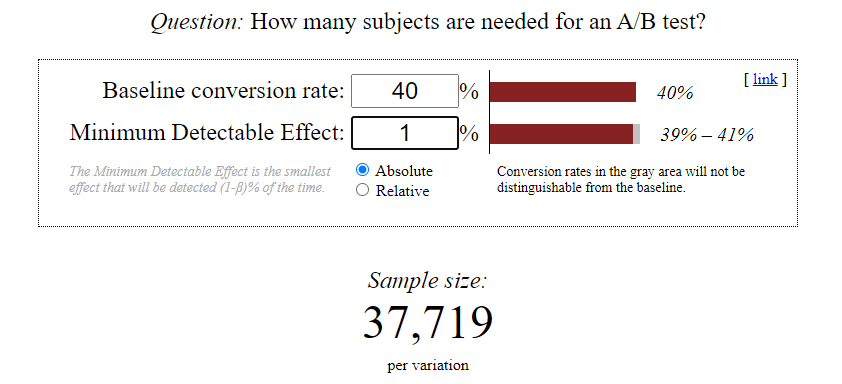

Пример А/Б теста, на проведение которого понадобится 21 год:

Предположим, трафик на сайте — 10 тысяч человек, конверсия в email — 3%. Вы хотите провести А/Б тест темы письма, чтобы понять, влияют ли эмодзи на Open Rate — отношение количества открытых писем к количеству отправленных.

Вариант А: Дарим 5000 рублей на ваш заказ!

Вариант Б: Дарим 5000 рублей на ваш заказ!

По результатам теста вы видите:

Open rate варианта А — 40%

Open rate варианта Б — 41%

Получается, что эмодзи незначительно влияют на конверсию.

Вводим эти данные в калькулятор:

Нам нужно будет отправить 37 719 писем на каждый из вариантов, чтобы понять, действительно ли эмодзи влияют на конверсию. Это 75 438 писем.

Как провести А/Б тест

Как запустить А/Б тест в Carrot quest

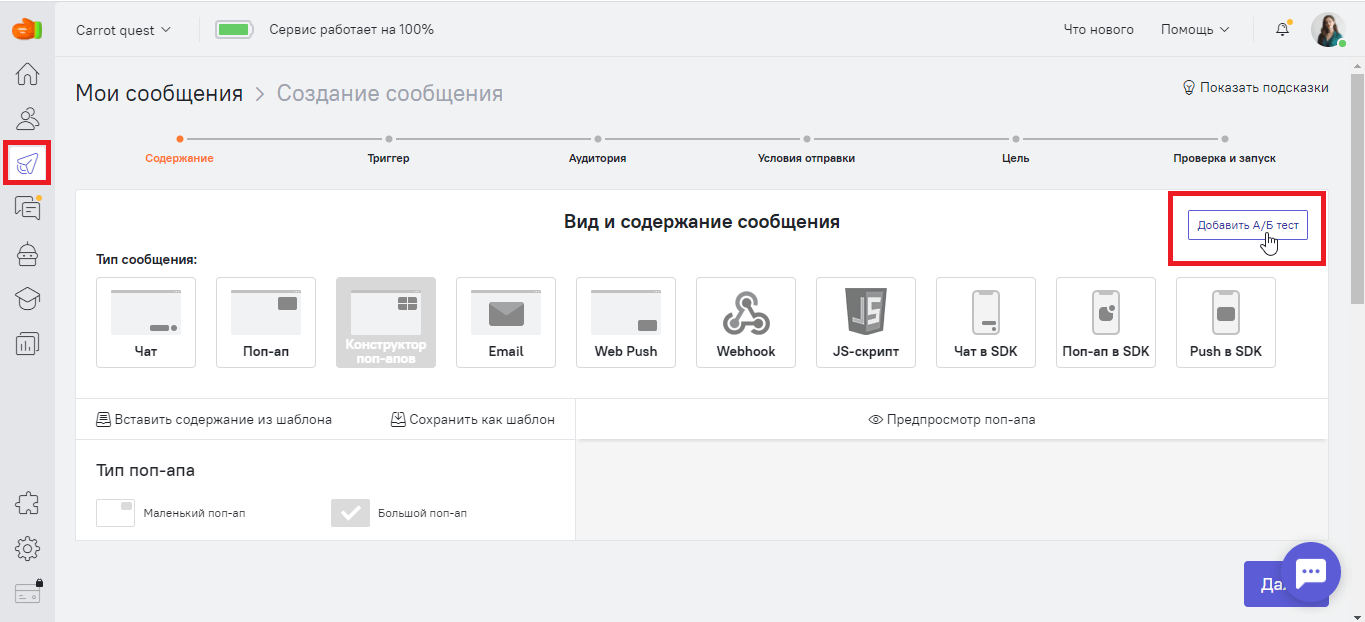

Зайдите в раздел «Триггерные сообщения», нажмите на кнопку «Создать сообщение» и выберите нужный тип. Создайте первый вариант сообщения нажмите на кнопку «Добавить А/Б тест»:

Ещё один вариант: вы можете выбрать уже существующее триггерное сообщение и создать для него А/Б тест.

После этого откроется раздел, в котором вы сможете сделать второй вариант. Carrot quest сам разделит аудиторию сообщения на две равные группы и покажет каждой свой вариант. Дальше вы ждете, когда в статистике сообщения наберется достаточно данных. В зависимости от трафика, на это может потребоваться от нескольких дней до нескольких месяцев.

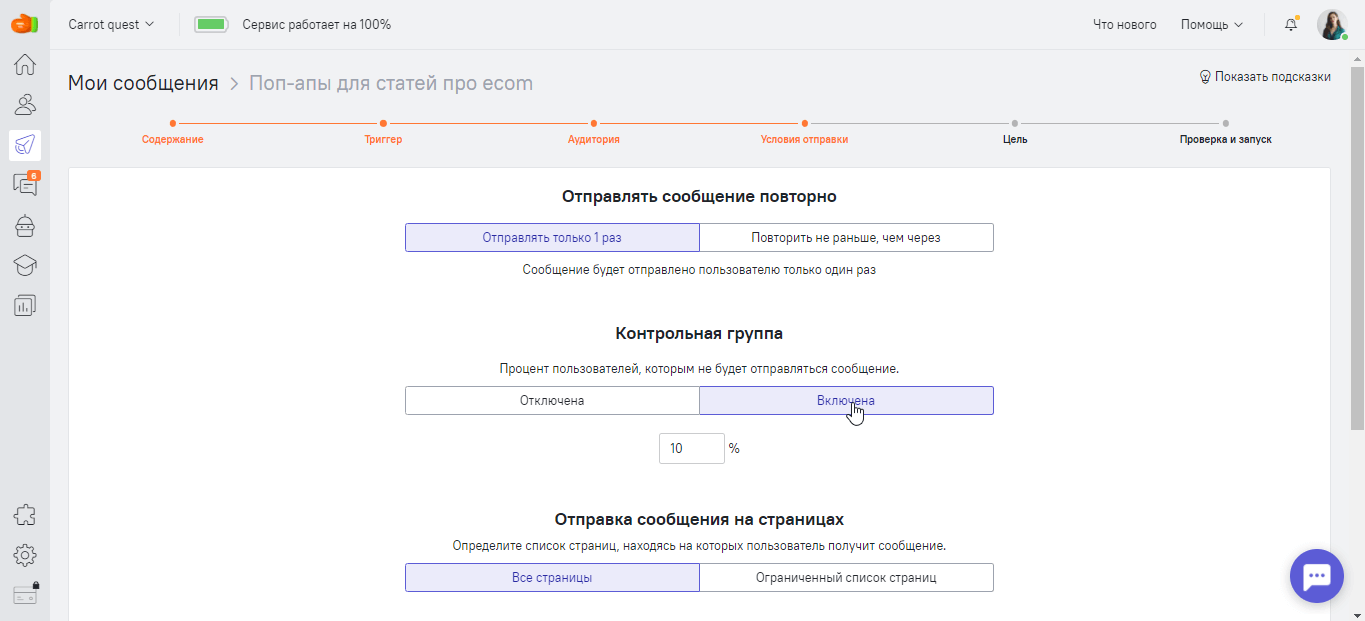

В разделе «Условия отправки» вы можете включить контрольную группу. По умолчанию она составляет 10% — это значит, что 10% посетителей сайта не увидят ни варианта А, ни варианта B. Вы можете задать своё значение. Но помните, чем меньше процент контрольной группы, тем дольше вы будете ждать, пока соберется статистика.

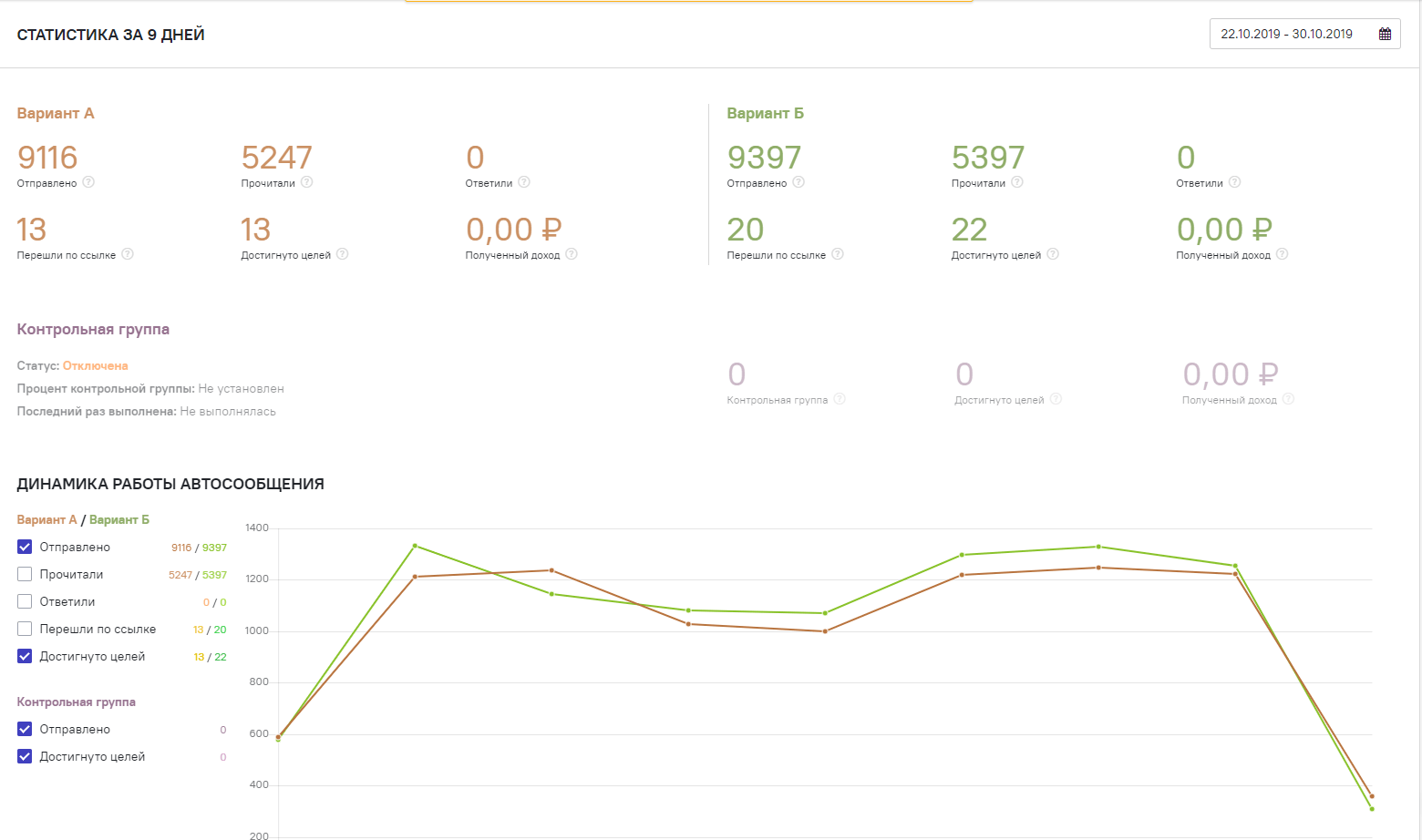

Чтобы узнать, какой вариант сработал лучше, кликните на иконку «Статистика» и перейдите в раздел «А/B тест»:

Вы можете посмотреть:

Данные выводятся рядом, чтобы вы могли сравнить цифры, а также в виде графиков:

Вы можете посмотреть, сколько денег принёс вам каждый из вариантов. Для этого при настройке автосообщения задайте цель (следующий шаг после Вид и Содержание). Это событие, которое должен выполнить пользователь после прочтения автосообщения (например, купить). В статистике вы сможете увидеть конверсию достижения цели и полученный доход.

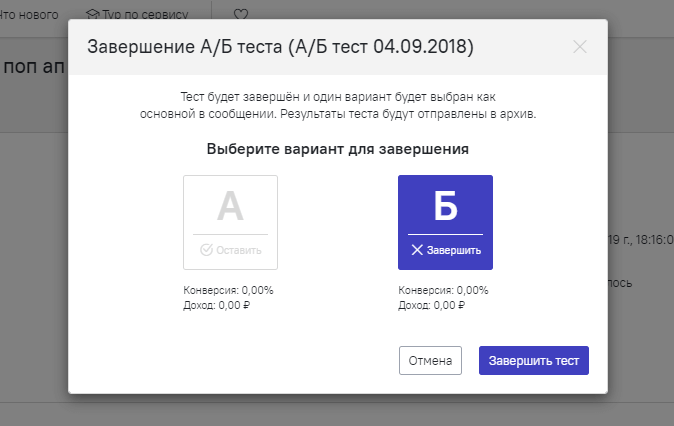

Как только вы набрали достаточно статистических данных и выбрали сообщение-победителя, завершите А/Б-тест. Для этого нажмите кнопку «Завершить тест» и выберите вариант сообщения, который хотите отключить:

Как только вы снова решите сравнить сообщение А с каким-либо другим, создайте новый А/Б тест на основе этого же сообщения. У одного сообщения может быть неограниченное количество А/Б-тестов. Историю всех закрытых А/Б-тестов можно посмотреть в архиве.

Посмотрите нашу видеоинструкцию о том, как запустить A/Б тест в Carrot quest:

Как оценивать результаты А/Б тестов

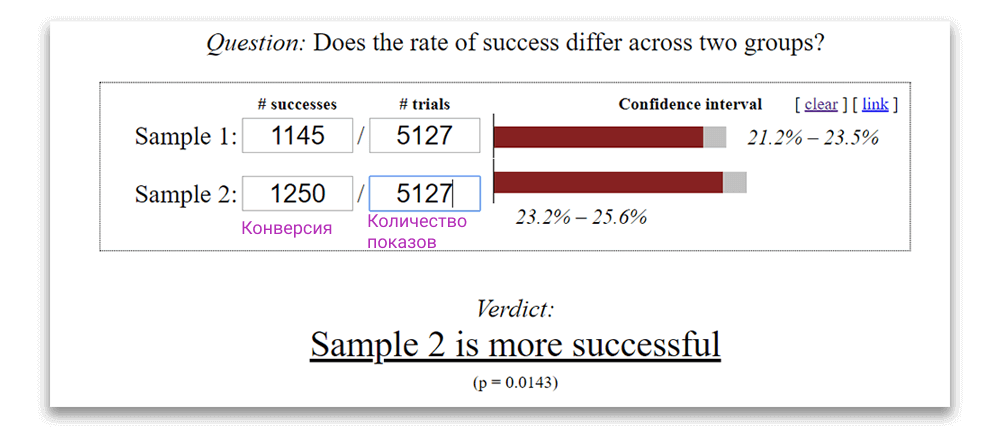

Чтобы понять, какой из вариантов был успешнее, воспользуйтесь калькулятором Эвана Миллера. Внесите в калькулятор количество показов и конверсию каждого из вариантов.

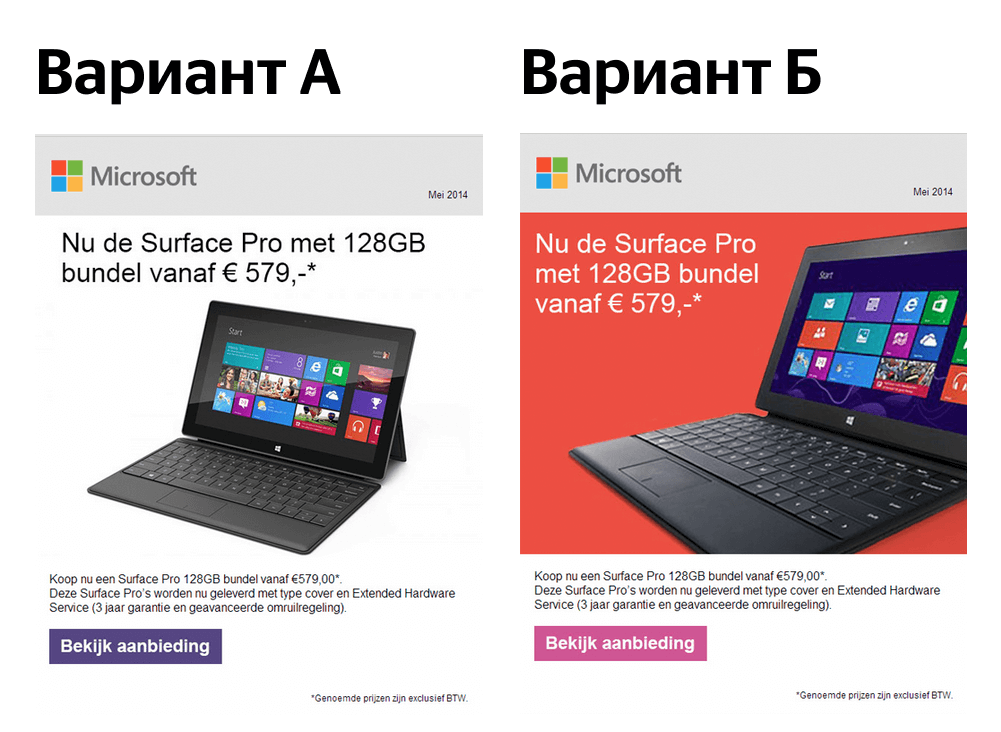

Допустим, вы запускаете А/Б тест с гипотезой о том, что новая цветовая гамма письма увеличит количество кликов:

В результате вариант А открыли 5127 раз, переходов было 1145. У варианта Б такое же количество открытий, а переходов — 1250. Калькулятор выдает результат, что вариант Б победил:

Важно, чтобы тестируемый элемент влиял на целевое действие: регистрацию, оплату или оставленный лид. Правильнее всего оценивать эффективность А/Б теста именно по этим параметрам.

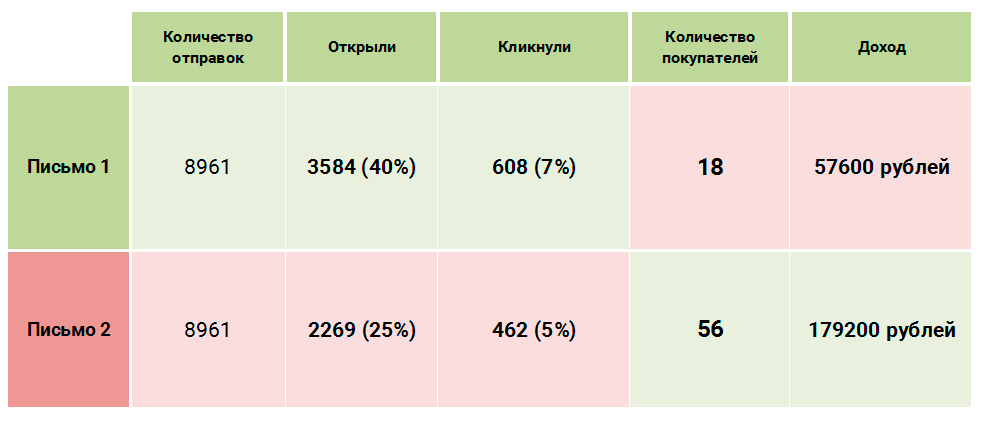

Какое из писем стоит признать победителем в А/Б тесте?

Несмотря на то, что пользователи лучше взаимодействуют с первым письмом, второе принесло больше продаж и, как следствие, денег. Открытия и клики — это здорово, но смотрите на конверсию в те действия, которые важны для бизнеса.

Бывает, что статистически значимого результата по А/Б тесту нет. Например, мы тестируем два поп-апа с разными текстами:

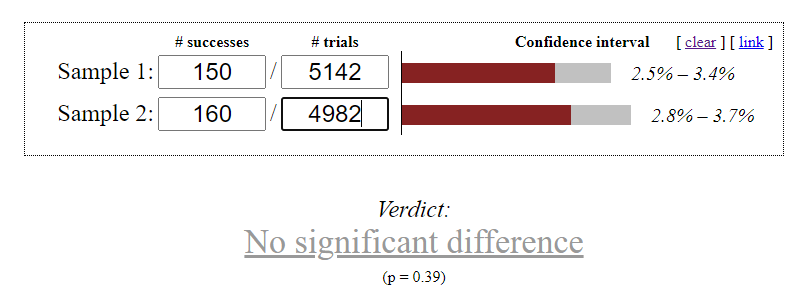

Вариант А: собрано 150 емейлов, 5142 показа, вариант Б: собрано 160 емейлов, 4982 показа:

В этом примере мы не получили статистически значимых данных, поэтому можно оставить любой из вариантов.

Какие еще бывают тесты

Если вы уже проверили все гипотезы и стандартных А/Б тестов оказалось недостаточно, присмотритесь к другим вариациям:

Топ-5 ошибок при проведении А/Б тестов

1. Отсутствие сегментации пользователей

Сегментация — это основа любой кампании по автоматизации маркетинга. Важно, чтобы клиенты получали релевантные сообщения. В противном случае А/Б тест может дать ошибочный результат, так как проигравшее на общей массе пользователей сообщение может оказаться выигрышным среди целевой аудитории.

Что еще можно почитать о сегментации:

2. Слишком маленькая аудитория для А/Б теста

Чем больше аудитория для А/Б теста, тем надежнее будет результат. Если в тесте приняли участие 4 человека, то голос каждого из них – это 25%. А если участников было 400 или 4 000, то данные можно считать репрезентативными.

3. Слишком много экспериментов в одном

Суть А/Б теста в том, чтобы выяснить, как влияет изменение конкретного элемента на конверсию в целевое действие. Поэтому важно менять не больше одного элемента за раз. Иначе вы не сможете сказать, что повлияло на успех письма: котик на картинке вместо собачки, большая красная кнопка CTA вместо простой текстовой ссылки, более удачная тема письма или всё сразу.

В Carrot quest для одного автосообщения вы можете последовательно настраивать неограниченное количество А/Б тестов. Например, сначала вы можете протестировать заголовок письма. Как только определите победителя и закончите тест, можете переходить к тестированию CTA, а затем текста сообщения.

Спасибо! Мы отправим всё на почту.

4. Надежда на чужой опыт

Некоторые маркетологи хотят обмануть всех и не проводить А/Б тест, а посмотреть результаты чужого кейса и внедрить сразу успешный вариант. Это большая ошибка, потому что отличается буквально всё. Только тест покажет, что работает в вашем случае, для вашей аудитории.

Вы с удивлением можете обнаружить, что у вас лучше работает зелёная кнопка, хотя только вчера прочитали кейс, где компания отказалась от зеленого в пользу красного и увеличила продажи в 2 раза. Это нормально. Верьте собственным данным.

5. Завышенные ожидания

Этот пункт связан со всеми предыдущими. Многие смотрят на успешные кейсы других компаний и считают, что А/Б тесты непременно повысят конверсию если не в два раза, то хотя бы на 30-40%. В реальности совсем не обязательно будет так. Разница в результатах может быть невелика, но даже она влияет на количество лидов или прибыль.

Запаситесь терпением. Ваш первый А/Б тест может не привести к росту конверсии, но не спешите отказываться от этого инструмента. Смысл в том, чтобы постоянно тестировать разные элементы, постепенно улучшая коммуникацию с пользователями и повышая конверсию шаг за шагом.

Статья впервые опубликована 14 июня 2017. 12 января 2021 года статья была обновлена.

Больше про А/Б тесты:

Екатерина Макарова

Контент-маркетолог Carrot quest

Евгений Аликин

Тимлид команды внедрения Carrot quest